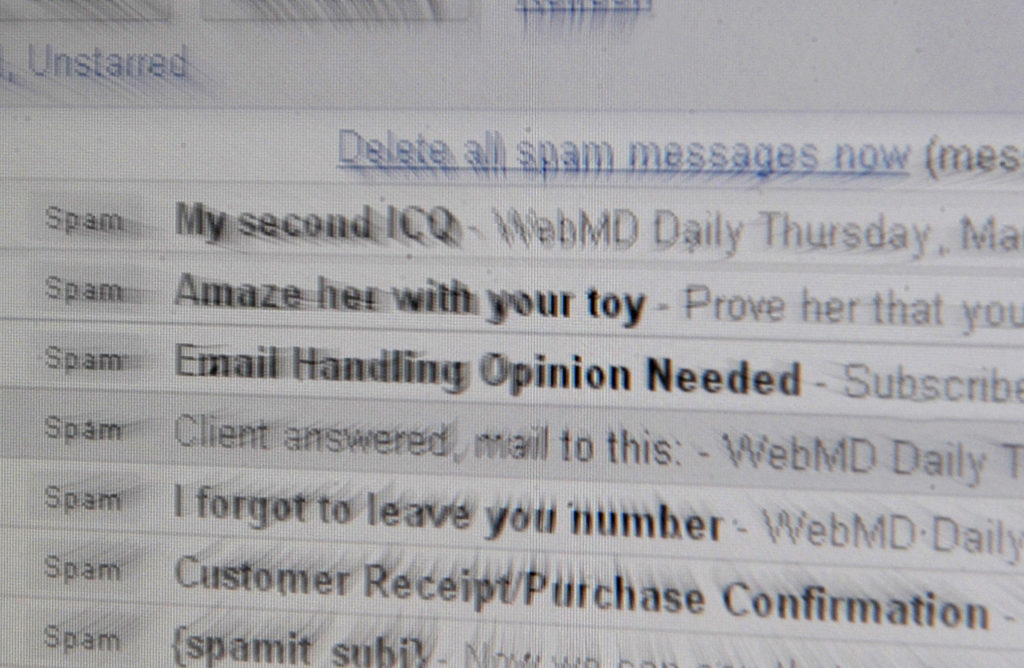

Изкуственият интелект е вече във вашия имейл. Финландска компания създаде продукт, който позволява на работодателите да сканират личните имейли на кандидат-работниците, за да преценят дали те са подходящо допълнение към компанията им.

Компанията Digital Minds представя изобретението си като нещо безобидно. Ако кандидатите дадат съгласието си, какъв е проблемът?

Истината е, че не знаем отговора на този въпрос. И това е проблемът, който прави толкова страшни новите навлизащи в личното ни пространство технологии, които могат да се окажат и дискриминационни.

Продуктът преглежда личните разговори на кандидатите за работа, за да генерира оценка за техните психологически черти, използвайки софтуер на IBM. Резултатът е профил на кандидата, базиран на т. нар. Пет големи личностни черти – отвореност към изживявания, разумност, екстровертност, съглашателство и невротичност. Това ще помага на работодателите да преценят дали даденият човек е подходящ за тях.

Digital Minds , стартирана от двама млади финландци през 2017 г., твърди, че до момента са направени хиляди подобни оценки на личността за десетки клиенти и че софтуерът напълно влиза в изискванията на регламента за личните данни GDPR.

Има няколко основни предимства на подобен инструмент. Методите за набиране на кадри към момента далеч не са перфектни, тъй като оценяването на автобиографии и интервютата лице в лице оставят много място за дискриминация. При интервютата често превес има въпросът дали кандидатът е симпатичен на работодателя, а не какви умения ще покаже в работата си.

Според изследване на Университета в Калифорния, базирано върху наблюдения за движението на работници в различни компании за период от 6 години, показва, че езикът, използван при писането на имейли, може лесно да предвиди кариерното развитие на работника.

Според анализа на използваната лексика онези, които не се вписват в политиката на фирмата, е много по-вероятно скоро да я напуснат – доброволно или не.

Не са правени обаче изследвания за оценка на предвидимостта на личните имейли, но се смята, че това също ще покаже положителен резултат. Това е инструмент, който може да замести интервютата лице в лице с нещо много по-евтино, достоверно и по-малко податливо на физически влияния.

Разбира се, нито един инструмент не може да гарантира, че някой няма да го измами. Ако практиката да се сканират имейлите на потенциални работници стане широко приложима, възможно е и да се появят инструменти, които да помогнат на кандидатите да „преиначат” имейлите си така, че да изглеждат подходящи.

Освен това този софтуер може да се окаже незаконен. Във Финландия е забранено работодателите да събират лични данни на своите работници или кандидати за работа, които не са директно свързани с дадена задача, дори въпросният човек да е дал съгласието си. Дали за изграждането на психопрофил чрез сканиране на имейли се събират лични данни, все още не е ясно.

Европейският регламент за личните данни забранява решения, базирани единствено на автоматизирани процеси, ако те създават „легални ефекти” върху някого. Разбира се тези разпоредби оставят прекалено много място за интерпретации.

Но това не е истинската опасност от инструменти като този. Софтуерът за сканиране на имейли на Digital Minds е пример за увеличаващото се значение на автоматичното взимане на решения. Прогресивно отнемаме силата от ръцете на човека, поверявайки я на алгоритми, които взимат решения по критерии, които все още не са прецизирани. Неяснотата в която се взимат тези решения е най-големият риск, който представляват тези нови технологични подходи.

Дори най-напредналите компании, разработващи изкуствен интелект, все още не могат да предвидят какъв ще е изходът от него. „Амазон” например се отказа от система за набиране на служители, базирана на изкуствен интелект, защото се оказа дискриминационна спрямо жените. Но не всяка компания би била толкова политически коректна.

Докато автоматизираното взимане на решения остава „черна кутия”, няма никакъв начин работниците, а дори и програмистите да знаят на каква база алгоритмите го правят. Търси ли софтуерът ключови думи, свързани с хобита, семейни планове, сексуални предпочитания или други черти, които работодателите могат да сметнат за нежелателни? Бил ли е отхвърлян кандидат-служител на базата на свои предишни действия, пол, религиозни или политически убеждения? Няма как да разберем.

Неяснотата около инструменти като този може да предизвика сериозен ответен отговор от страна на гражданите, особено когато автоматизираното взимане на решения вече започва да има голям ефект върху човешкия живот.

Това вече се случва в Европа. Франция има широкообхватна система за контролиране на скоростта; властите в Дания разработиха инструмент, който идентифицира децата в риск от изоставяне; в Италия пък лекуването на пациенти в системата на общественото здраве е базирано на автоматизиран анализ на данни.

Холандия разчита на система за „рискова идентификация”, за да се откриват лесно и бързо банкови измами, а учителите в някои училища в Словения разчитат на автоматизирани инструменти за засичане на „проблемни” деца. В Полша министерството на правосъдието представи система, която веднъж дневно автоматично възлага дела на съдии из цялата страна „без емоции” или „влияние”.

Може би тези инструменти са разработени с добри намерения, но докато не ги направим по-прозрачни, хората ще започнат да губят доверие в компаниите и правителствата, които ги използват.