Изкуственият интелект е във възход през последните няколко години и е очевидно, че той ще промени коренно живота на всички хора на планетата. Причината е, че почти няма да остане незасегната сфера от живота ни, в която технологията няма да властва.

Към момента изкуствен интелект помага в много дейности. Той е полезен например при архивистиката и разчитането на текстове от документи, които с годините са се увредили. Технологиите, базирани на изкуствен интелект умело се използват в администрирането на процеси, особено в областта на услугите.

Вероятно вече сте разговаряли с чат-бот, докато сте опитвали да разберете кога ще пристигне пратката ви или ако сте опитвали да се свържете с мобилния си оператор, за да проверите сметката си.

За съжаление, попадайки в лоши ръце, технологията може да има и опасно приложение.

Особено популярни в последните години са измамите по телефона. Робот набира произволен номер и се представя за определен човек. Опасността става още по-голяма, когато технологията, след известен процес на обучение, може да наподоби и дори напълно да копира гласа на наш познат, близък или дори роднина.

Попитахме ChatGPT: Вярно ли е, че съветската армия освободи България? Ето и отговора

Едно такова обаждане може да ни струва трицифрена, дори и по-голяма сума.

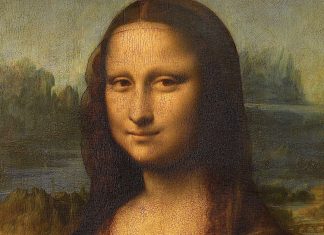

Особено популярни през годините станаха и deepfake видеа – дълбоки фалшификати, които показват известна личност да говори или прави неща, които в действителният живот тя никога не е казвала или правила.

Доста чести са и измамите с порнографско съдържание, при които честа жертва са известни личности. Напоследък това се случва и с не толкова популярни хора, дори и с деца.

Как работи технологията?

Според службата за информационна сигурност на Университета във Вирджиния, deepfake е изкуствено изображение или видео (серия от изображения), създадено с помощта машинно обучение.

Процесът на създаване на сложни deepfakes включва два алгоритъма. Единият произвежда възможно най-добрите фалшиви копия на реални изображения. Другият модел е обучен да открива слабости при генерирания продукт и ако засече такива, „връща“ видеото за доработка на първия модел. Този процес се повтаря, докато фалшификатът не премине всички тестове.

Основната цел на deepfake е да повлияе на хората да повярват, че се е случило нещо, което не се е случило. Всеки, който има способността да създава дълбоки фалшификати, може да пусне дезинформация и да ни повлияе да се държим по начин, който ще придвижи дневния му ред по някакъв начин. Базираната на deepfake дезинформация може да причини хаос както в малък, така и в голям мащаб.

Как да разпознаем с deepfake видео или аудио?

При видеата е много важно да наблюдаваме изражението на лицето. Елементите, върху които можем да се концентрираме, са изражението дали то отговаря на думите, които изрича човекът, движението на очите – много често се случва мигането да става на по-чести или по-редки интервали или дори да липсва, въпреки че с напредването на технологиите тези недостатъци постепенно се изчистват, синхрона на устните с това, което се говори, неспецифични сенки или дори липса на сенки по лицето, неестествени движения или мимики на лицето и тялото.

На втори план е проверката на казаното. Например, ако видим видео с образа на Владимир Путин, който заявява, че е обявил война на Запада и ще натисне ядреното копче, най-доброто, което може да се направи е да се направи проверка на фактите.

Това става най-лесно като бързо проверим в Гугъл за подобно изказване, а след това и в конкретни медии, на които имаме доверие. Можем да прегледаме подробно и социалните мрежи за коментари по тази тема и да проследим откъде всъщност тръгва разпространението на подобно видео.

Хубаво е да се проверят и институционалните сайтове, като в горния пример например посетим сайта на руския президент, на министерството на отбраната или на някоя от службите за сигурност.

„С нарастването на качеството на дълбоките фалшификати ще бъде трудно да се различи истинското от изкуственото“, съветва Линдзи Грейс, доцент в катедрата по интерактивни медии в университета на Маями.

Според нея потребителят на видеоклипове трябва да е достатъчно проницателен, за да задава въпроси и да се рови във всяка информация, свързана с тях – коментари, метаданни, източник на разпространение, контекст и т.н.

Всъщност това, в което се провалят моделите за засичане на лъжливо или недостоверно съдържания, базирани на изкуствен интелект, е именно контекстът. Компютърът не може да засече дали казаното отговаря на предхождащите го преди това събития.

„Важно е да практикувате няколко доказани стратегии, [като] проверка на източника. За дълбоки фалшификати на политически фигури, заслужаващи новини акаунти или популярно съдържание също има онлайн ресурси за проверка на такова съдържание“, обяснява доц. Грейс.

Специалистите по комуникации смятат, че най-доброто противодействие на дезинформацията и фалшивите новини е добрата информираност – както за обществения и политическия живот, но също и за рисковете, които се крият зад разпространението на подобни технологии.

Един от лидерите в киберсигурността NortonLifeLock обобщава измамите, на които можем да станем жертви заради deepfakes. Това са:

- Фишинг измами;

- Крадене на данни или разрушаването им;

- Всякакви видове измами;

- Порнография;

- Опетняване на репутацията;

- Манипулация на изборите;

- Социално инженерство;

- Автоматизирани дезинформационни атаки;

- Кражба на самоличност;

- Финансова измама;

- Шантаж.

15 полезни съвета, които позволяват разкриването на фалшиви видеа

Компанията препоръчва 15 неща, които можем да направим, за да разобличим един фалшив клип.

Неестествено движение на очите. Движенията на очите, които не изглеждат естествени – или липсата на движение на очите, като липса на мигане, трябва да бъдат червен флаг за опасност.

Неестествени изражения на лицето. Когато нещо не изглежда както трябва с лицето, това може да сигнализира за манипулация.

Неестествено позициониране на части от лицето. Ако лицето на някого сочи една посока, а носът му сочи друга, трябва да сте скептични.

Липса на емоции. Ако забележите липса на промяна в изражението при емоционално изказване, това трябва също да ви усъмни.

Неестествена поза или размери на тялото. Ако формата на тялото на човек не изглежда естествена или има неудобно или непоследователно позициониране на главата или тялото, това със сигурност е знак за манипулация.

Китай открива нов фронт с изкуствен интелект за водене на информационната война

Неестествено движение на тялото. Ако човекът от видеото прави неестествени движения, например проявява неочаквана гъвкавост и танцува, без това да е специфично за поведението му или прави сложни акробатични номера или прави прекалено резки движения.

Неестествено оцветяване. Често се случва тенът на кожата да не отговаря на реалното лице на човека. Често липсва обезцветяване или неправилно разположени сенки.

Коса, която не изглежда истинска. Няма да видите къдрава или хвърчаща коса, защото фалшивите изображения няма да могат да генерират тези индивидуални характеристики.

Зъби, които не изглеждат истински. Алгоритмите може да не са в състояние да генерират отделни зъби, така че липсата на очертания на отделни зъби може да е улика.

Замъгляване или неправилно подравняване. Ако краищата на изображенията са замъглени или визуалните елементи са неправилно подравнени.

Непостоянен шум или звук. Огледайте се за лошо синхронизиране на устните, роботизирано звучащи гласове, странно произношение на думи, цифров фонов шум или дори липса на звук.

Изображения, които изглеждат неестествени, когато се забавят. Ако гледате видео на екран, който е по-голям от вашия смартфон, или имате софтуер за редактиране на видео, който може да забави възпроизвеждането на видео, можете да увеличите мащаба и да разгледате изображенията по-отблизо. Увеличете мащаба на устните, за да видите дали има синхрон с говора.

Несъответствия в хаштаговете. Има криптографски алгоритъм, който помага на създателите на видеоклипове да покажат, че техните видеоклипове са автентични. Алгоритъмът се използва за вмъкване на хаштагове на определени места във видеоклип. Ако хаштаговете се променят, тогава трябва да подозирате, че видеоклипът е манипулиран.

Цифрови отпечатъци. Блокчейн технологията може също да създаде цифров отпечатък за видеоклипове. Въпреки че не е сигурна, тази базирана на блокчейн проверка може да помогне за установяване на автентичността на видеоклипа. Ето как работи. Когато се създаде видеоклип, съдържанието се регистрира в книга, която не може да бъде променяна. Тази технология може да помогне за доказване на автентичността на видеоклип.

Обратно търсене на изображения. Търсенето на оригинално изображение или обратното търсене на изображение с помощта на компютър може да разкрие подобни видеоклипове онлайн.

Още новини от деня – четете тук